✿ 5/16 活動報告更新のお知らせ ✿

最新の画像保護技術の情報とソースコードを提供するための記事として、「2025年最新の画像保護技術とソースコード」を全体公開しました!

■□■ 第3ゴール挑戦中 ■□■

皆さまから多くのご支援を賜り、プロジェクト開始から2週間でネクストゴール「150万円」を達成することができました。

深く御礼を申し上げるとともに、私たちからのメッセージと第3ゴール「300万円」について、お伝えさせていただきます。

第3ゴールを達成した場合には、最新の画像保護研究を直接利用できる環境を皆さまに提供します。

この環境の提供は、皆さまからアカデミックな技術に対する率直なご意見をいただき、「今後こうなって欲しい」といったフィードバックを受け取ることで、研究開発に活かせると考えています。

ぜひ、引き続きお力添えをいただけますと幸いです。

■□■ 目標達成の御礼 ■□■

初日より多くのご支援を賜り、プロジェクト開始の告知から23時間で目標金額「100万円」を達成することができました。

深く御礼を申し上げるとともに、私たちからのメッセージとネクストゴール「150万円」について、お伝えさせていただきます。

詳細: https://camp-fire.jp/projects/832033/view/activities/682105#main

自己紹介

この度は、本プロジェクトにご関心を持っていただきありがとうございます。

私たちは、東京大学の研究員および卒業生を中心とする有志の研究チームで、アーティスト、クリエイターの著作権を保護するための研究と開発に取り組んでいます。

メンバーの専門分野は、知的財産法、情報法、計量経済学、コンピュータビジョン、機械学習など多岐にわたりますが、いずれも著作権保護に関する社会的課題に強い関心を持つメンバーが集まっています。

将来的には、全世界の人が安心して作品を投稿できる著作権保護プラットフォームを開発し、普及を目指しています。

詳細: https://lovlet.jp/about-us

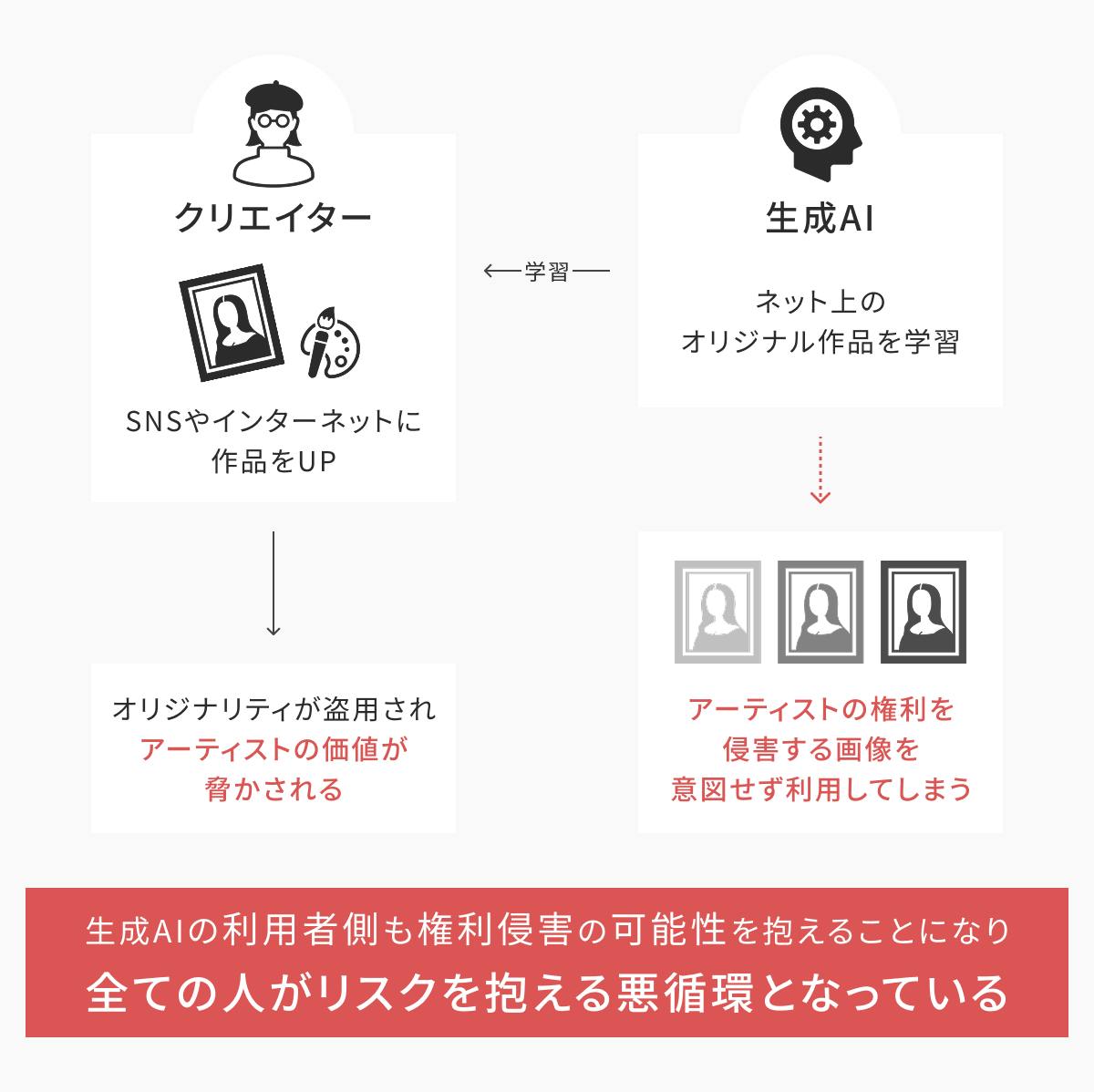

プロジェクトの背景

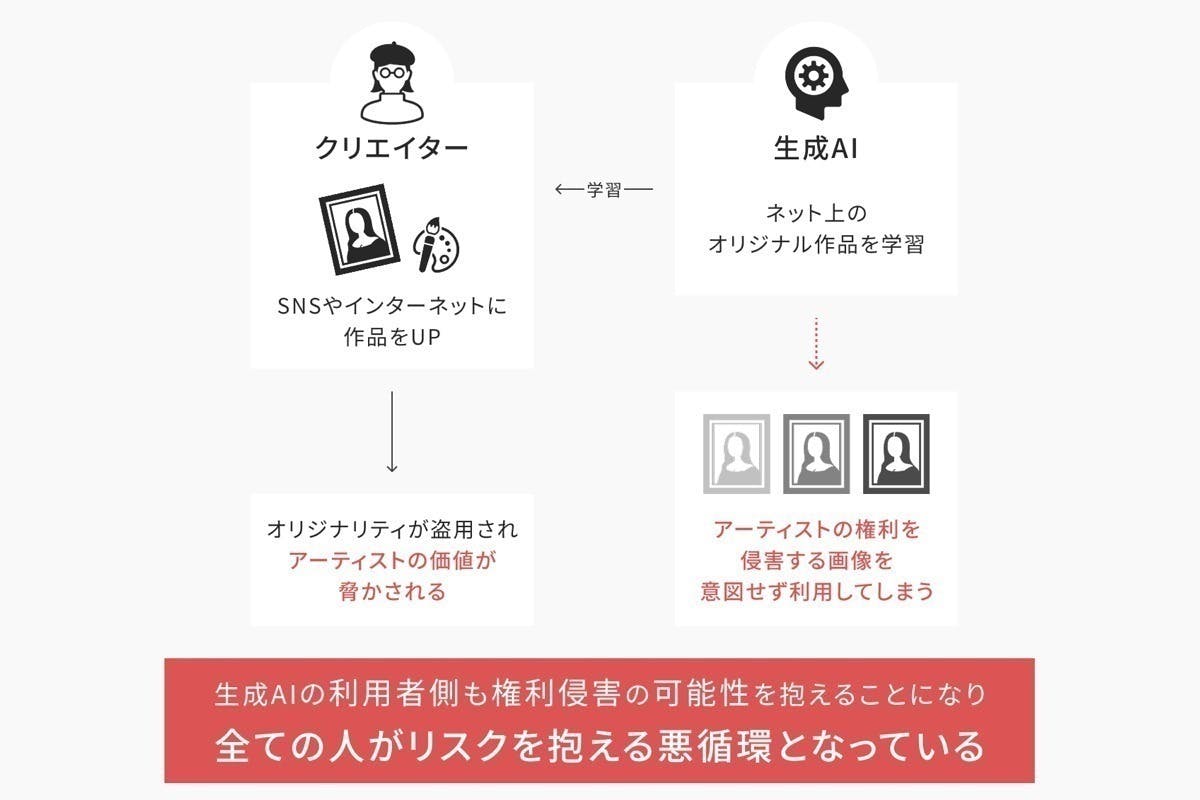

生成AIの学習における著作権侵害や無断使用が近年深刻な問題となっています。

画像生成AIや音楽生成AIにおいては、オリジナルの作品が無断で利用され、その結果、アーティストやクリエイターが経済的損失を被っているという事態が起きています。

世界各国で訴訟が起きており、アメリカでは、著作権を持つアーティストやクリエイターが、自身の作品が無断でAIに学習され、生成されたコンテンツに使用されているとして、生成AIを提供する企業に対して訴訟を起こしています。日本でも、著作権法を適用した生成AIの利用に関する議論が進んでいるものの、現行の法律ではAIが生成したコンテンツに対しての権利が明確でないなどの課題があり、今後の法改正が求められています。

このような問題を解決するためには、業界全体での協力や、法的な枠組みの見直し、クリエイターの権利を保護するための技術的な対策が必要となります。さらに、生成AIを利用したコンテンツが市場に氾濫する中で、偽作や盗用のリスクも増加しており、コンテンツの真正性や品質を確保するための対策も急務です。

実現したいこと

このプロジェクトの第一段階では、著作権保護を目的とした画像保護プラットフォームを構築し、どなたでも使える形で公開します。

このプラットフォームは、主に次の2つの役割を担います。

1. 生成AIによる学習からコンテンツを守り、自身の作品を保護できる環境を提供します。

2. 自身が生成AIを使用していないことを明示し、作品の信頼性を示せる環境を提供します。

現段階でも、プロジェクトの実現に向けて、現行の生成AIによる学習の仕組みや法律を踏まえた画像保護プラットフォームのプロトタイプを開発し、公開しています。

次のものは、プラットフォームのトップ画面です。

次のものは、プラットフォームの作品公開画面です。

プロトタイプのリリース

2025年1月19日にテスト版をリリースし、Xアカウント(@lovlet_jp)を通して、多くの方々からフィードバックをいただいています。

画像保護プラットフォームの詳細は、こちらに記載しています。

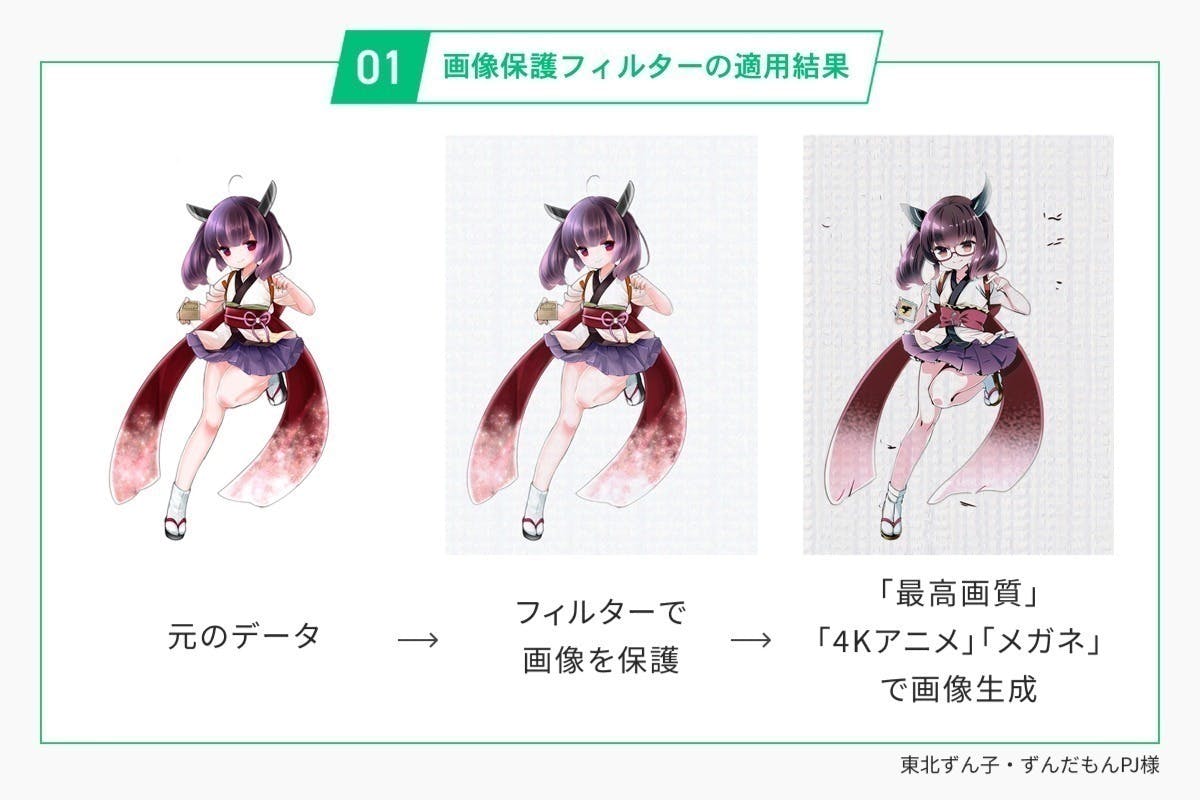

画像保護技術の開発

私たちは、プラットフォーム開発の他、画像保護のための研究開発に取り組んでおり、現在、画像保護技術を無償で提供しています。

画像保護技術の詳細は、こちらに記載しています。

詳細: https://lovlet.jp/image-protection-filter

◼️ 世界各国の取り組み

画像保護技術は、世界各国の研究機関で研究されており、同分野の研究としては、次のような取り組みがされています。

こちらは、本プロジェクトでも参考としている研究です。

MetaCloak (2024)

CAAT (2024)

VCPro (2024)

https://arxiv.org/abs/2408.08518

リターンについて

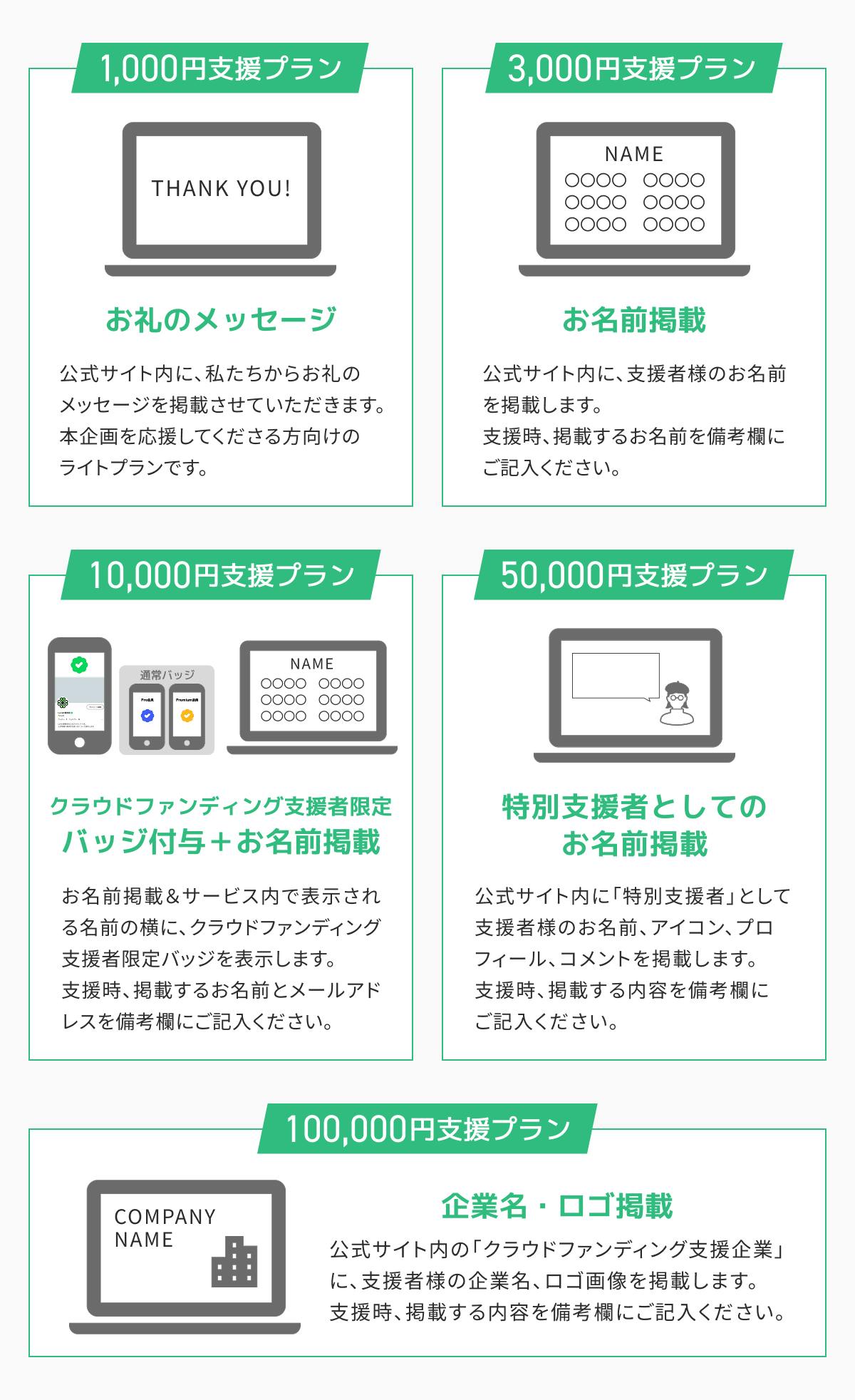

◆ 1,000円 支援プラン【お礼のメッセージ】

公式サイト内に、私たちからお礼のメッセージを掲載させていただきます。

本企画を応援してくださる方向けのライトプランです。

個別のリターンはありませんので、予めご了承ください。

◆ 3,000円 支援プラン【お名前掲載】

公式サイト内の「クラウドファンディング支援者」に、支援者様のお名前を掲載します。

支援時、掲載するお名前を備考欄にご記入ください。

◆ 10,000円 支援プラン【クラウドファンディング支援者限定バッジ付与+お名前掲載】

お名前掲載の他、サービス内で表示される名前の横にクラウドファンディング支援者限定バッジを表示します。

支援時、掲載するお名前とサービス内でご使用されるメールアドレスを備考欄にご記入ください。

◆ 50,000円 支援プラン【特別支援者としてのお名前掲載】

公式サイト内に「特別支援者」として、支援者様のお名前、アイコン、プロフィール、コメント(任意)を掲載します。

支援時、掲載する内容を備考欄にご記入ください。

◆ 100,000円 支援プラン【企業名・ロゴ掲載】

公式サイト内の「クラウドファンディング支援企業」に、支援者様の企業名、ロゴ画像を掲載します。

支援時、掲載する内容を備考欄にご記入ください。

※ 補足

備考欄には文字数制限があり、内容が収まりきらない場合がございます。

その際は、メッセージ機能にて別途お送りいただければ対応します。

次のものは、「◆ 10,000円 支援プラン」 のクラウドファンディング支援者限定バッジのイメージです。

ご協力者の募集について

クラウドファンディング支援とは別途、本課題の解決と普及のために、ご協力いただけるクリエイターさま(写真家、漫画家、コスプレイヤー、イラストレーター、その他のメディアを使用する職業の方)を募集しています。

ご関心のある方は、こちらのフォームからお問い合わせください。

https://forms.gle/KP4bLkLmEvnVbRnv6

スポンサー企業の募集について

クラウドファンディング支援とは別途、ご支援いただける企業さまを募集しています。

ご関心のある方は、こちらのフォームからお問い合わせください。

https://forms.gle/DP5vKxbNQtKUS9vK8

資金の使い道

皆様からお預かりした資金は、主に「プラットフォームの運用費」に使用させていただきます。

支援資金が目標金額である100万円を上回った場合は、次の費用に使用させていただきます。

・プロジェクトの運営費(人件費)

・プロジェクトの普及活動費

・プラットフォームの開発費

・プラットフォームの改善費

・関連技術の研究費

支援資金が目標金額を大幅に上回った場合は、次の費用に使用させていただきます。

・画像サイズや枚数上限の拡張費

・音楽・映像・その他メディアを対象とした、新たなプラットフォームの構築検討

本支援は、アカデミックな研究を実際に活用していただくための運用費の調達を一番の目的としています。一方で、目標金額を大幅に超えた場合には改めて検討し、その結果を続報としてお知らせいたします。

スケジュール

本プロジェクトの支援募集期間については、次の通りです。

2025/3/13(木)〜2025/5/31(土)23:59まで

リターンについては、募集終了後から順次開始し、6月末までに全てのリターンを実施完了予定です。その後は、皆さまからの支援資金、フィードバックを元に上記の内容を実施していく予定です。

最後に

作品を多くの人に楽しんでもらうために公開しているにもかかわらず、不安や課題を抱えているアーティストやクリエイターが大勢います。本プロジェクトは、小さな研究チームではありますが、この課題を解決するために全力を尽くしたいと考えています。ご支援・ご協力をいただけますと、大変ありがたく思います。

最新情報については、Xアカウント(@lovlet_jp)を中心に発信してまいりますので、こちらもフォロー、応援いただけたら幸いです。

最新の活動報告

もっと見るクラウドファンディング達成の御礼

2025/06/16 13:00この度は、クラウドファンディング「アーティスト・クリエイターの権利を保護する学術研究プロジェクト」に多くのご支援を賜り、誠にありがとうございました。本クラウドファンディングは2025年3月13日より募集を開始し、79日間で316名の方々から1,710,000円のご支援をいただき、目標金額の171%を達成することができました。皆さまの温かいご支援に、心より御礼申し上げます。支援金の使途について今回のクラウドファンディングは、本課題に対する研究費の募集ではなく、多くの方が安心して作品を公開できる場を継続的に提供するための運用費の調達を一番の目的としていました。これは、研究者各自が獲得している科研費などの研究費は、研究以外の用途には使用できないことによります。そのため、今回いただいたご支援金は、目標金額を超えた分も含め、全てプラットフォームの運用費に充てさせていただきます。私たちのサービスでは、すべてのユーザー(未ログインの閲覧者を含む)に対して、投稿されたすべてのオリジナル画像について、アクセスされるたびに署名付きURLを毎回発行しています。これらの仕組みにより、機械による画像の収集・解析を困難にしながら、人間の閲覧者にとっては快適な閲覧体験を提供しています。運用には決して安価でないコストがかかりますが、皆さまからのご支援金を大切に活用し、5年、10年と継続的な運営を目指してまいります。リターン実施完了のお知らせご支援への感謝として、掲載をご希望された支援者様のお名前を、特設ページにて掲載させていただいております。リンク先をご確認のうえ、お名前の誤記や記載漏れ等がございましたら、お手数ですが、CAMPFIREのメッセージ機能よりご連絡ください。URL: https://lovlet.jp/supportersクラウドファンディング支援者限定バッジの付与対象者は、ログイン後「設定」ページにて、バッジの表示・非表示を選択いただけるようになっています。対象者で設定項目が表示されない場合も、同様にメッセージ機能よりご連絡ください。URL: https://lovlet.jp/settings最後に今後も、長期的な運用と、技術の進展や状況に応じた適切なアップデートを継続していけるよう努めてまいります。また、サービス内の設定ページから有料会員(月額550円から)としてご登録いただくことで、今後の運用を支える大きな助けとなります。もしご賛同いただけましたら、ぜひこちらからのご支援もご検討いただけますと幸いです。長期的な課題解決に向けて尽力してまいりますので、今後ともどうぞよろしくお願いいたします。Lovletプロジェクトメンバー一同 もっと見る2025年最新の画像保護技術とソースコード

2025/05/16 10:00この度は、本プロジェクトにご関心をお寄せいただきありがとうございます。本記事では、「2025年最新の画像保護技術とソースコード」と題し、現在公開されている最新の画像保護技術の中から、学術的に認められているものに限定して、全てソースコード付きでご紹介いたします。本記事は、これらの技術を皆様個人でご利用いただく他、民間企業や団体によるサービスの提供、また本課題の学術的状況や問題意識の共有につながることを期待しています。以下、技術名称の横に記載の括弧内の文言は、各研究が発表された、または発表予定の国際会議の名称を表しています。また、掲載している図は、各論文および公開されているソースコードから引用しています。■ Anti-DreamBooth (ICCV'23)論文:Van Le, Thanh, et al. "Anti-dreambooth: Protecting users from personalized text-to-image synthesis." Proceedings of the IEEE/CVF International Conference on Computer Vision. 2023.コード:https://github.com/VinAIResearch/Anti-DreamBoothDreamBoothと呼ばれる技術を利用すると、特定の人物の画像をわずかに学習させるだけで、その人物の新たな画像を生成することができます。Anti-DreamBoothは、こうしたDreamBoothの悪用から個人を保護することを目的に開発された技術です。この技術を利用することで、画像がDreamBoothの学習に使用された場合でも、低品質の画像しか生成できないようにすることが可能です。■ Photoguard (ICML'23)論文:Salman, Hadi, et al. "Raising the cost of malicious AI-powered image editing." Proceedings of the 40th International Conference on Machine Learning. 2023.コード:https://github.com/MadryLab/photoguardPhotoguardは、上記の技術と同様の目的を持ちつつ、より幅広い画像生成モデルに対応した防御を提供する技術です。Anti-DreamBoothは、比較的シンプルかつ軽量なことから導入しやすい一方、DreamBoothによる顔画像の不正学習の防止に特化しています。これに対し、Photoguardは、様々な画像や生成モデルに対応した防御手段を実現しており、より汎用的な保護性能を持つ技術と言えます。■ Mist (ICML'23)論文:Liang, Chumeng, et al. "Adversarial example does good: preventing painting imitation from diffusion models via adversarial examples." Proceedings of the 40th International Conference on Machine Learning. 2023.コード:https://github.com/psyker-team/mistMistは、Textual Inversion、Stable Diffusion、NovelAIといった、より実践的かつ広く利用されている画像生成モデルに対する防御を提供する技術です。本技術は、画像のスタイルやコンテンツの模倣を防ぐことを目的に設計されています。■ MetaCloak (CVPR'24)論文:Liu, Yixin, et al. "Metacloak: Preventing unauthorized subject-driven text-to-image diffusion-based synthesis via meta-learning." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2024.コード:https://github.com/liuyixin-louis/MetaCloakMetaCloakは、上記の技術と同様の目的を持ちながら、転送可能な防御効果(Stable Diffusion v1.5, v2.1といったモデルを跨いでの防御効果)を備えている防御技術です。また、Mistでは対象としていなかったLoRAに対する防御性能があることが実証されています。■ CAAT (CVPR'24)論文:Xu, Jingyao, et al. "Perturbing attention gives you more bang for the buck: Subtle imaging perturbations that efficiently fool customized diffusion models." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2024.コード:https://github.com/CO2-cityao/CAAT/tree/mainCAATは、北京交通大学、Google Research、セントラルフロリダ大学によって共同開発されたもので、MetaCloak同様に転送可能性を備えた防御技術です。論文では、Anti-DreamBooth・Mistと比較して、顕著な有効性を持つことが述べられています。また、Anti-DreamBooth・Mistと比較して、約2倍の速度で実行可能であることから、より実用的な保護手段といえます。■ EditShield (ECCV'24)論文:Chen, Ruoxi, et al. "Editshield: Protecting unauthorized image editing by instruction-guided diffusion models." European Conference on Computer Vision. Cham: Springer Nature Switzerland, 2024.コード:https://github.com/Allen-piexl/Editshield/EditShieldは、PhotoGuardなどの技術と同様の目的を持ちつつ、特に指示誘導型の画像編集に対する防御を提供する技術です。本技術を適用することで、生成された画像の品質が、元画像と比べて、大きく低下することが確認されています。また、その他の種類の編集に対しても有効であり、PhotoGuardと比較して、優れた性能を示すことが確認されています。なお、PhotoGuard・EditShieldと比較して、より優れた性能を示すGuardDoorと呼ばれる技術もあるので、興味のある方はこちらもご覧ください。■ Nightshade (IEEE S&P'24)論文:Shan, Shawn, et al. "Nightshade: Prompt-specific poisoning attacks on text-to-image generative models." 2024 IEEE Symposium on Security and Privacy (SP). IEEE, 2024.コード:https://github.com/Shawn-Shan/nightshade-releaseNightshadeは、学習対象の画像に「毒」を仕込むことで、指示誘導型の画像編集に対する防御を実現する技術です。本技術を用いることで、適用した画像が100枚未満であっても、Stable Diffusionなどの画像生成モデルにおけるプロンプトの挙動を破壊できることが確認されています。なお、公開されているソースコードは、研究目的の基本実装であるため、個人で使用する場合には、公式ウェブサイトに掲載されているPC向けソフトウェアが利用ができます。■ ACE (ICLR'25)論文:Zheng, Boyang, et al. "Targeted Attack Improves Protection against Unauthorized Diffusion Customization." The Thirteenth International Conference on Learning Representations.コード:https://github.com/caradryanl/ACEACEは、Mistの開発者らによって提案された新たな防御技術です。本技術は、最新の画像生成モデルであるStable Diffusion v3に対して、LoRA耐性の有効性を示した最初の研究とされています。なお、2025年5月現在では、ソースコード上で「Mist v2」として、安定版が公開されています。■ AtkPDM (AAAI'25)論文:Shih, Chun-Yen, et al. "Pixel is not a barrier: An effective evasion attack for pixel-domain diffusion models." Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 39. No. 7. 2025.コード:https://github.com/AlexPeng517/AtkPDMAI分野に関するトップ国際会議の一つ「NeurIPS'24」の「Safe Generative AI」ワークショップにおいて、これまでの画像保護技術に関する重要な見落としと脆弱性が指摘されました。AtkPDMは、これらの課題に対処した新しい対象への防御技術です。本研究に至るまでの研究動向や詳細については、支援者限定記事「2025年最新の画像保護技術と研究動向」でもご紹介しているので、興味のある方はこちらもご覧ください。■ EditGuard (CVPR'24) / OmniGuard (CVPR'25)論文1:Zhang, Xuanyu, et al. "Editguard: Versatile image watermarking for tamper localization and copyright protection." Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2024.論文2:Zhang, Xuanyu, et al. "OmniGuard: Hybrid Manipulation Localization via Augmented Versatile Deep Image Watermarking." Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2025.コード:https://github.com/xuanyuzhang21/EditGuardEditGuardは、画像に目に見えない形で著作権情報を埋め込む技術であり、さらに、改ざんが行われた箇所を正確に特定できるウォーターマーキング技術です。論文では、著作権情報の復元、改ざん箇所の特定精度の高さが実証されており、実用性の高いウォーターマーキング手段といえます。最近では、本技術の改良版であるOmniGuardが、コンピュータビジョン分野のトップ国際会議の一つである「CVPR'25」にて採択されており、さらなる改良が見られています。■ WAM (ICLR'25)論文:Sander, Tom, et al. "Watermark Anything with Localized Messages." The Thirteenth International Conference on Learning Representations.コード:https://github.com/facebookresearch/watermark-anythingWAMは、Meta社によって提案されたもので、EditGuard同様、画像に目に見えない形で著作権情報を埋め込むだけでなく、改ざんが行われた領域を特定することが可能なウォーターマーキング技術です。現時点で、透かしの位置を特定できる手法は、WAMとEditGuardのみであり、両者はこの分野において先進的な技術と言えます。従来の技術では、画像の一部を切り貼りする「スプライシング」操作などに対して脆弱でしたが、WAMは、画像が切り貼りされた場合にも対処可能です。さらにWAMは、EditGuardを上回る性能を持つだけでなく、同一画像内に埋め込まれた複数の透かしを検出・抽出できる初の技術とされています。■ DiffusionShield (NeurIPS'23) (SIGKDD'25)論文1:Cui, Yingqian, et al. "DiffusionShield: A Watermark for Data Copyright Protection against Generative Diffusion Models." NeurIPS 2023 Workshop on Diffusion Models.論文2:Cui, Yingqian, et al. "DiffusionShield: A watermark for data copyright protection against generative diffusion models." ACM SIGKDD Explorations Newsletter 26.2 (2025): 60-75.コード:https://github.com/Yingqiancui/DiffusionShieldDiffusionShieldは、画像に目に見えない形で著作権情報を埋め込むだけなく、それが画像生成AIの出力で再生成されるように設計されているウォーターマーキング技術です。本技術は、画像の品質を損なうことなく高精度でウォーターマークを検出できるだけでなく、ガウシアンノイズ、ぼかし、グレースケール変換、JPEG圧縮、リサイズといった各種の加工・攻撃に対して高い耐性を持ちます。さらに、長文メッセージの埋め込みができる点も特徴です。長いメッセージを埋め込めることは、より決定的な侵害の証拠を提供できるという点で、透かし技術において重要な要素となります。このような研究の需要は年々高まっており、2025年4月には、深層学習分野におけるトップ国際会議の一つである「ICLR'25」にて、生成AIに関するウォーターマーキング技術の初のワークショップが開催されました。 今後は、こうしたワークショップでの議論も、着目すべき情報となります。URL:https://sites.google.com/view/genai-watermark/本記事では、学術的に認められている一部の研究に絞ってご紹介しましたが、より最先端の研究については、arXivといったプレプリントサーバー(査読前の学術論文をインターネット上で公開する仕組み)からご覧いただけます。本記事が、個人の方々だけでなく、より大きな団体や民間企業の皆さまにとって参考となり、実際の導入にも繋がれば嬉しく思います。現在実施中のクラウドファンディングにおいても、第3ゴールを達成した際には、これらの技術の中から選定し、皆様に触っていただける環境の提供を予定しています。クラウドファンディングは、2025年5月31日まで受付中ですので、もし本取り組みにご協力いただける方は、引き続き応援、ご支援いただけますと幸いです。Lovletプロジェクトメンバー一同 もっと見る2025年最新の画像保護技術と研究動向

2025/04/04 03:12こちらの活動報告は支援者限定の公開です。

コメント

もっと見る